Des laboratoires ainsi que des associations et centres de l’EPFL seront présents tout au long de la journée pour présenter au public des projets de recherche en lien avec l’Intelligence Artificielle.

Laboratoires

Hall du Rolex Learning Center

Améliorer notre compréhension de l’environnement

Laboratoire de science computationnelle pour l’environnement et l’observation de la Terre (ECEO)

L’intelligence artificielle au service de l’environnement.

Le laboratoire ECEO développe des algorithmes d’intelligence artificielle qui enrichissent notre compréhension de l’environnement. L’objectif est d’analyser des images obtenues à différentes échelles, qu’elles proviennent d’un simple téléphone portable ou d’un satellite, puis de les utiliser pour innover dans les sciences environnementales. Cela inclut des domaines tels que la conservation animale, l’étude du métabolisme urbain, ou encore le suivi des récifs coralliens menacés de disparition si des actions ne sont pas entreprises.

Piloter un drone-oiseau

Laboratory of Intelligent Systems

Contrôle basé sur l’apprentissage pour les drones inspirés par les oiseaux

Les visiteurs pourront essayer de piloter le drone inspiré de l’avifaune en simulation. Un écran montrera comment l’IA procède.

Reproduire l’agilité humaine

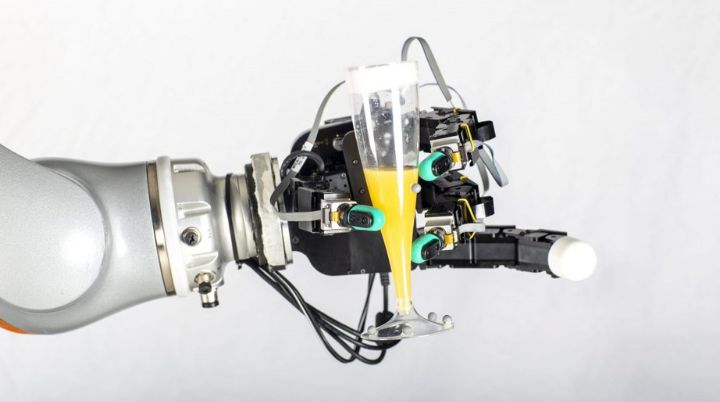

Learning Algorithms and Systems Laboratory (LASA)

Lancer adaptatif robuste avec un robot manipulateur

Les humains lancent des objets avec une aisance déconcertante, s’adaptant instinctivement à des environnements changeants sans même y penser. Pour les robots, reproduire cette agilité est un défi de taille. Chaque lancer nécessite une séquence complexe de mouvements, impliquant des milliers de calculs en une fraction de seconde. Nos recherches visent à doter les robots de cette capacité en utilisant l’intelligence artificielle. Grâce à nos algorithmes, les robots peuvent désormais générer des mouvements de lancer efficaces et fluides en temps réel, ouvrant la voie à une nouvelle génération de robots plus agiles et polyvalents.

Forum Rolex

Exposition organisée par

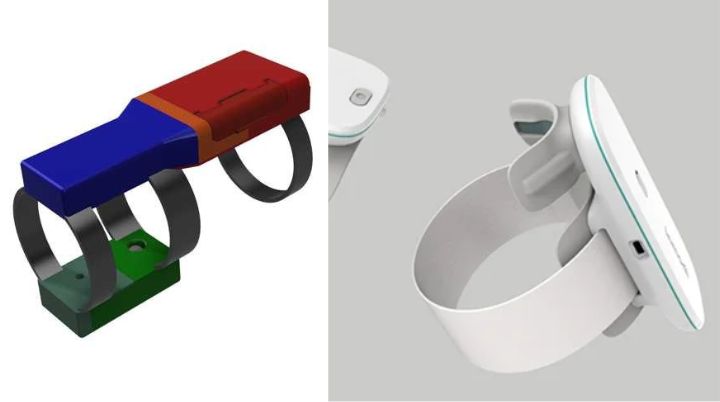

Collecter et analyser des données médicales à l’aide d’un dispositif portable

Laboratoire des systèmes embarqués (ESL)

Sensemodi: Évaluation acoustique et cinématique de l’articulation du genou

Sensemodi propose un dispositif portable intelligent, rapide, fiable et non invasif qui évalue la santé des articulations grâce à des capteurs collectant des informations sur le genou en mouvement. Une fois le dispositif en place, le patient effectue des exercices prédéfinis (flexion-extension, assis-debout, marche, etc.) permettant de recueillir les données nécessaires à une évaluation précise. Cette combinaison innovante de modalités de capteurs, de biométrie et d’analytique fondée sur l’apprentissage automatique offre une évaluation exhaustive de l’intégrité des articulations.

VersaSens: Une plateforme multimodale extensible pour des dispositifs portables avec fonctionnalités Edge-AI

VersaSens est un concept de plateforme polyvalente et personnalisable, concrètement mise en œuvre en tant qu’outil pour stimuler la recherche sur les capteurs embarqués. Nous avons testé trois cas d’utilisation: la surveillance de la toux, la classification du rythme cardiaque et la détection des crises épileptiques. Ce dispositif modulable peut être porté à différents endroits du corps selon l’application: par exemple, au poignet pour suivre le rythme cardiaque et extraire des données vitales de l’utilisateur en temps réel. Les efforts de développement axés sur la faible consommation d’énergie du système permettent de collecter des données pendant plus de 24 heures consécutives.

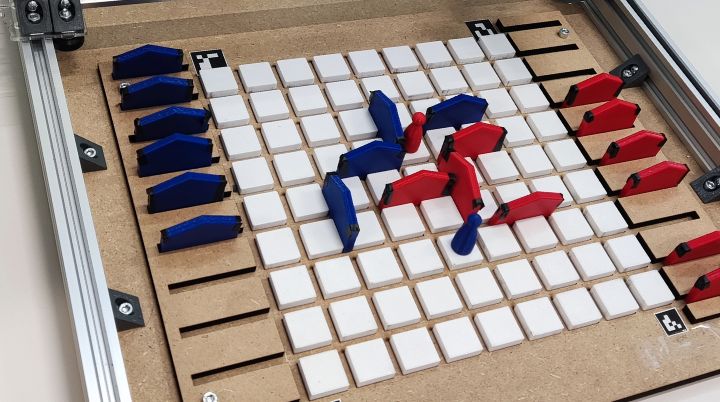

Jouer contre une intelligence artificielle

Laboratoire de théorie et applications d’analyse de données (DATA)

2024sp-quoridor

Dans le cadre du cours « Making Things Intelligent » du Prof. Christoph Koch, qui exploite et affine les compétences des étudiants en matière de pensée computationnelle et de construction d’artefacts logiciels avancés, QuoriBot vise à créer une version modifiée du jeu de plateau physique appelé Quoridor, un jeu stratégique de construction de labyrinthes, où un·e joueur·euse affronte un adversaire informatique sur le plateau de jeu.

Quoridor est un jeu à deux joueur·euse·s où les pièces sont disposées sur le côté opposé du plateau. A chaque tour, chaque joueur·euse peut soit déplacer sa pièce dans n’importe quelle direction cardinale (haut, bas, gauche, droite), soit placer un mur sur le plateau, changeant ainsi le chemin pour les deux. Les murs ne peuvent pas être déplacés une fois bougés. La première personne à atteindre l’autre côté gagne la partie.

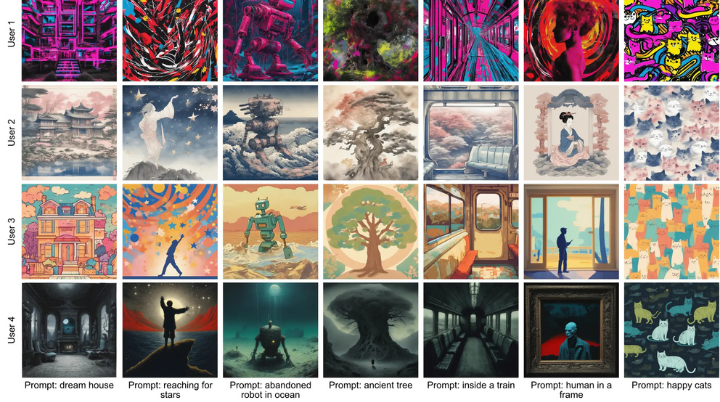

Élargir les possibilités des IA génératives

Visual Intelligence and Learning Laboratory (VILAB)

ViPer : Personnalisation visuelle des modèles génératifs via l’apprentissage des préférences individuelles

Chaque personne utilisatrice des IA génératives aura ses préférences parmi les différentes images générées par un même prompt. ViPer est une méthode qui personnalise la sortie des modèles génératifs pour les aligner sur les préférences visuelles des personnes. Pour ce faire, les préférences générales de l’utilisateur·trice sont saisies une seule fois et un modèle génératif est conditionné en fonction de ces préférences, sans qu’il soit nécessaire de recourir à des prompts détaillés. Cette démo permet de personnaliser la génération d’image, en fonction des préférences visuelles de chacun grâce à leurs commentaires sur une série d’images.

4M-21 : Un modèle de vision pour des dizaines de tâches et de modalités

Nous percevons le monde à travers différentes modalités (comme nos cinq sens). Chacune d’entre elles nous fournit une vue distincte d’une même réalité physique, et lorsqu’elles sont combinées, nous comprenons mieux le monde autour de nous. 4M permet d’entrer une variété de modalités dans un réseau neuronal qui n’est traditionnellement entrainé que sur une seule modalité (par exemple entrer du texte sur ChatGPT), et se concentre sur une seule tâche (par exemple générer du texte).

Le 4M peut entrer et sortir plusieurs combinaisons de modalités ou tâches et constitue ainsi un modèle très polyvalent. Il ne s’agit encore que de recherche fondamentale, mais nous pouvons imaginer de nombreux domaines d’application comme en géologie ou biologie, où le modèle peut traiter différents types de modalité (par ex. différents capteurs, des images, du texte, etc.) Cette démonstration prédit différentes modalités comme les champs sémantiques, la géométrie, les palettes de couleur, etc.

Un mobilier intelligent pour personnes à mobilité réduite

Biorobotics Laboratory (BioRob)

Équiper le mobilier quotidien d’une capacité mobile est une façon prometteuse de faciliter la vie de son utilisateur·trice, en particulier pour les personnes à mobilité réduite. Nous proposons un ensemble de meubles d’assistance mobiles et explorons les cas d’utilisation destinés à aider les personnes

dans leurs activités quotidiennes à la maison. Nous nous concentrons sur l’important défi de coordonner les mouvements d’une multitude de meubles mobiles dans un espace limité et partagé avec les personnes utilisatrices. Nous proposons également un pipeline de perception basé sur l’IA pour évaluer l’état d’un scénario de vie arbitraire. Cette estimation pourrait alors être utilisée comme signal de retour en temps réel pour le contrôle autonome en boucle fermée du mobilier mobile.

Un robot capable de s’adapter à tous les terrains

Robot morphique pour tous les terrains

Notre robot multimodal fait preuve d’une locomotion améliorée en reconfigurant activement sa forme, ce qui lui permet de s’adapter efficacement à des terrains variés avec une détection minimale de l’environnement. Construit avec une structure souple, il passe d’une forme plate à une forme sphérique pour conduire, rouler et nager, naviguant ainsi de manière autonome dans des environnements complexes. Contrairement aux robots classiques qui s’appuient fortement sur des systèmes de perception, ce robot tire parti d’une morphologie bio-inspirée pour s’adapter au terrain sans sacrifier l’efficacité. Lors de tests, il a parcouru un chemin difficile de 4,5 km à travers des paysages montagneux, aquatiques et urbains, faisant preuve d’une polyvalence, d’une efficacité énergétique et d’une robustesse accrues. De tels robots adaptables pourraient faire progresser considérablement la navigation autonome pour des applications dans le domaine de la surveillance de l’environnement, de l’intervention en cas de catastrophe ou de l’exploration de terrains extraterrestres.

Créer un jumeau numérique de la mouche

Les mouches qui se trouvent dans votre cuisine pourraient bien détenir la clé de la création d’une meilleure intelligence artificielle. Le laboratoire du Prof. Ramdya reconstitue la nature numériquement pour comprendre comment les mouches excellent dans la détection, la prise de décision et l’action dans des environnements complexes du monde réel. Pour ce faire, le génome de la mouche est modifié, son cerveau cartographié et elle est observée en action, t unjumeau numérique de celle-ci

est alors crée. L’objectif est de découvrir des informations pouvant inspirer la conception de robots plus autonomes, capables d’explorer le monde sans limites.

Dans cette démonstration, les visiteurs peuvent interagir avec le jumeau numérique de la mouche, NeuroMechFly, pour observer comment on peut contrôler ce qui semble être une tâche assez simple : la locomotion. Cette démonstration montre comment des signaux simples – avancer, reculer ou se déplacer latéralement – peuvent être plus facilement utilisés par le cerveau pour déclencher la marche en mobilisant des contrôleurs de moteur en aval. A contrario, il est plus compliqué de contrôler la marche au niveau de chacune des six pattes individuellement.

Connecter les cerveaux et les machines

Les neurosciences et la recherche sur l’intelligence artificielle connaissent toutes deux des révolutions à grande échelle. Dans le domaine des sciences du cerveau, nous avons désormais accès à des quantités sans précédent de mesures expérimentales grâce à une neurotechnologie toujours plus performante. Parallèlement, les progrès de l’intelligence artificielle produisent des modèles qui apprennent à effectuer des tâches écologiques avec des performances comparables à celles de l’homme. L’une des principales découvertes à l’intersection de ces deux domaines est que certains modèles d’intelligence artificielle fonctionnent de la même manière que les cerveaux biologiques.

Plus précisément, nous

1. testons la similarité entre le modèle et le cerveau sur de nombreux enregistrements cérébraux provenant de la plateforme Brain-Score, en découvrant que les objectifs des tâches telles que la classification des objets et la prédiction du mot suivant prédisent l’alignement sur le cerveau ;

2. construisons de nouveaux modèles avec une neuroanatomie récurrente simple et un alignement amélioré sur le cerveau et le comportement, ainsi que des capacités de robustesse et de généralisation ;

3. appliquons nos meilleurs modèles pour contrôler de manière non invasive l’activité cérébrale et pour prédire les effets comportementaux des interventions neuronales. Les modèles alignés sur le cerveau ont le potentiel de combler des lacunes critiques dans les neurosciences, la médecine et la technologie, en améliorant notre compréhension des systèmes intelligents de type humain.

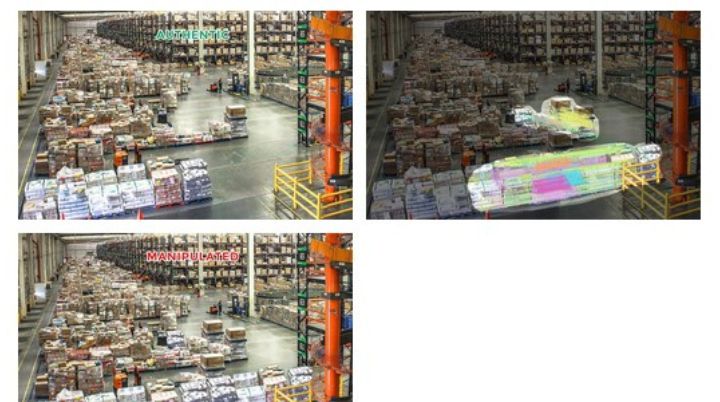

Améliorer la détection de deepfakes

Multimedia Signal Processing Group (MMSPG)

Spot the Fake

“Spot the Fake” est un démonstrateur en ligne sous la forme d’un jeu conçu pour tester notre capacité à distinguer des images authentiques d’images générées par l’intelligence artificielle. À chaque tour, le ou la joueur·euse voit deux images côte à côte : l’une authentique et l’autre créée par une IA. L’objectif est d’identifier correctement la photo créée par IA.

Pour chaque sélection correcte, les joueur·euse·s gagnent des points, tandis que trois erreurs entraînent la fin du jeu. Le jeu conserve un niveau de difficulté constant tout au long de la partie, ce qui permet aux joueur·euse·s de se concentrer sur l’amélioration de leurs compétences en matière de reconnaissance, sans avoir à subir la pression d’une complexité croissante ou de contraintes de temps. En tant que démonstrateur, “Spot the Fake” offre une expérience attrayante et éducative, soulignant le défi croissant que représente la distinction entre les contenus authentiques et ceux générés par l’IA. Le

joueur·euse peut suivre sa performance en fonction du nombre de réponses correctes et est encouragé·e à améliorer ses compétences en évitant les erreurs.

À vous de jouer : testez votre capacité à identifier les “deepfakes” !

Prédire les comportements humains dans des environnements complexes

Visual Intelligence for Transportation (VITA)

La capacité à prédire précisément les comportements humains est cruciale pour les systèmes robotiques, leur permettant de réagir aux mouvements des agents environnants. Cette compétence est d’autant plus essentielle dans le domaine de la mobilité autonome, où véhicules sans conducteur et robots interagissent directement avec les humains. L’anticipation des événements futurs constitue un fondement de l’intelligence, une notion profondément étudiée en sciences cognitives.

Voici une démonstration qui détecte et prédit la posture corporelle humaine.

Autres stands

La formation continue à l’EPFL

Hall RLC

L’EPFL Extension School est responsable d’étendre l’accès à l’enseignement et aux ressources de l’EPFL, pour proposer une offre de formation continue dans des domaines de pointe. Découvrez l’ensemble de leurs programmes sur leur stand lors de cette journée !

Un photomaton Intelligent

Hall RLC

Imaginez-vous sur le campus du futur et prenez la pose ! Développé par Pixora, ce photomaton allie intelligence artificielle et créativité pour créer un souvenir inoubliable.

L’association étudiante AI Team

Hall RLC

L’AI Team de l’EPFL est une association d’étudiants dédiée à l’exploration du potentiel de l’intelligence artificielle à travers des projets pratiques, la collaboration et l’innovation. Venez échanger avec ces étudiant·e·s passionné·e·s de la communauté IA de l’EPFL !